关注我们的 WhatsApp 频道, TikTok 与 Instagram 以观看最新的短视频 - 开箱,测评与第一手新闻资讯。

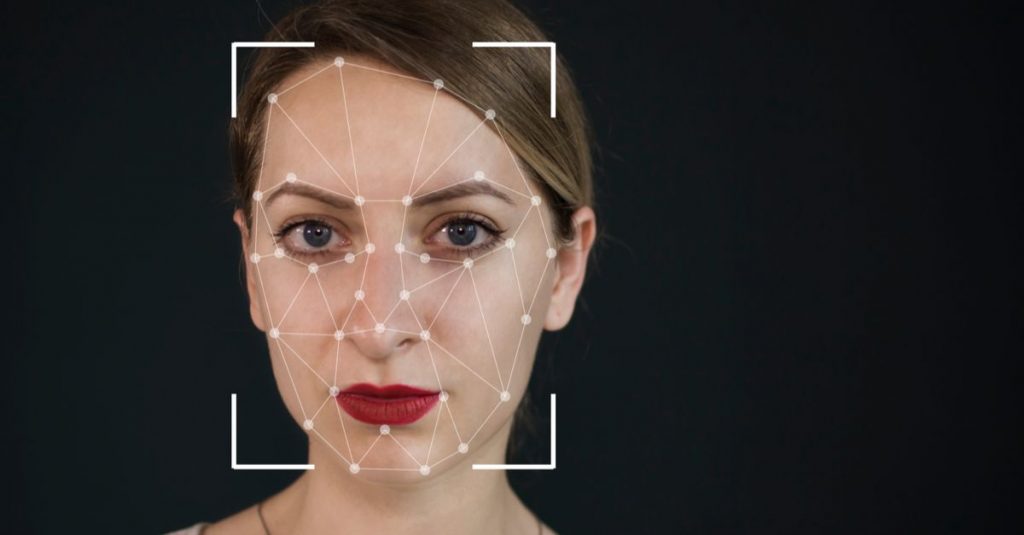

Deepfake,是英文“deep learning”(深度学习)和“fake”(伪造)的混成词,专指用基于人工智能的人体图像合成技术。此技术可将已有的图像和影片叠加至目标图像或影片上。Deepfake的用途颇为广泛,近日更是有媒体报道,Deepfake遭滥用于制作虚假的名人性爱影片和报复性色情媒体!

今天, 一家名为Deep Trace Labs的公司发布了一份备受期待的报告《DeepFake现状:前景、威胁和影响》,他们在报告中探讨了在网站、论坛和移动应用中普遍存在的DeepFake。

Deep Trace发现,目前网上有14678个DeepFake视频,其中96%是色情视频,并且大部分都是著名女演员的脸,被转移到色情明星的身体上。事实上,大多数DeepFake的目标是女性,而大多数非色情的目标是男性。YouTube上超过90%的DeepFake视频都来自西方世界,从女演员、音乐家到政客和企业界人士。

但Patrini强调,这不仅仅是一种仅限于西方的现象。 “在DeepFake色情网站上,近三分之一的视频中出现了非西方题材,其中韩国流行歌手占了目标对象的四分之一,”Patrini说道。“这表明,DeepFake色情是一种日益全球化的现象。”

Deep Trace还指出,DeepFake创作社区正在增长。 Patrini认为,其中一些社区以提供非法或边缘化的内容而闻名,DeepFake创作工具的商品化,可能会导致该技术继续产出有害和恶意的使用案例,例如网络欺凌或政治宣传。

Patrini认为:“我不会说这些用途具有明确的正面作用,但从表面上看,它们肯定不是恶意的。”此外,由于DeepFake不只是发生在西方的现象,Deep Trace认为,这需要全球采取行动,打击恶意使用。

更多科技新闻,记得关注TechNave中文版!

【资料来源】