关注我们的 WhatsApp 频道, TikTok 与 Instagram 以观看最新的短视频 - 开箱,测评与第一手新闻资讯。

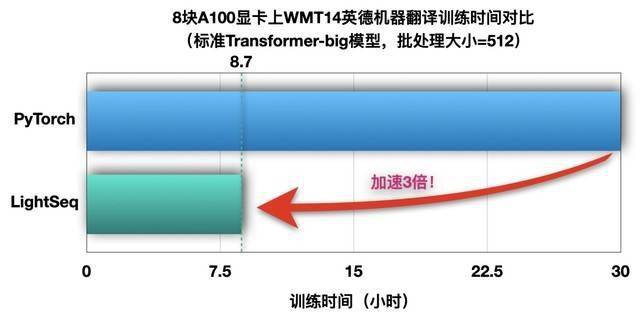

字节跳动火山翻译团队宣布,将推出LightSeq训练加速引擎,并向全球开发者开源。这是业界首款完整支持Transformer模型全流程加速的训练引擎,最快可提速3倍以上,帮助从业者大幅提升模型生产效率。

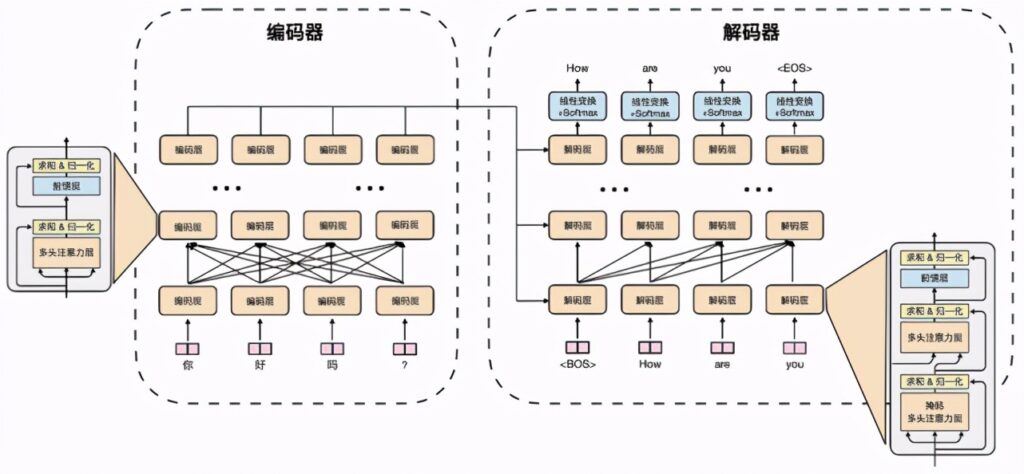

Transformer 是自然语言处理、电脑视觉等 AI 技术领域最常用的基础模型,被广泛应用在机器翻译、文本生成、文本摘要、图像处理、时间序列预测等任务中。训练和推理则是 AI 技术的两个主要过程,相当于学习知识和解决问题。

据悉,LightSeq 训练加速引擎能够支持 Transformer 的完整加速,从词嵌入层、编码层、解码层,到最后的损失函数层,业内首次实现了全流程支持。

另外, LightSeq 的训练速度极快,相比主流的序列生成库,LightSeq 最快只需要三分之一的时间就能完成训练。

目前,字节跳动已经开源了机器学习平台 Klever、联邦学习平台Fedlearner、高性能分布式训练框架 BytePS 等重磅项目。

据火山翻译团队负责人介绍,LightSeq训练加速引擎具有功能全面、简单易用的特点,并提供了丰富的二次开发工具。通过插入自定义层或修改几个命令行参数等方式,用户可以在各种流行训练库上轻松使用LightSeq。

自 2017 年被Google提出之后,Transformer 模型成为了众多 NLP 任务以及部分 CV 任务的主流模型。但由于硬件资源匮乏,很多实验室或者公司都无法训练很大的模型,而降低批处理大小等措施又会导致训练时间成倍增加。

因此,如何利用有限的资源尽快训练出模型成为了亟待解决的问题。针对这一痛点,字节跳动推出了 LightSeq 训练加速引擎,对 Transformer 训练的整个计算过程进行了优化。

更多科技资讯,请继续守住TechNave中文版!

【资料来源】