关注我们的 WhatsApp 频道, TikTok 与 Instagram 以观看最新的短视频 - 开箱,测评与第一手新闻资讯。

Apple今日宣布了三项新举措,旨在通过自家的技术和产品功能,提供儿童安全保护,其中包括iMessage敏感图像筛查、iCloud儿童性虐待内容检测,以及Siri和搜索功能相关内容的支持。

Apple表示,保护儿童是一项重要责任,考虑到这一点,Apple将努力在此类功能上不断更新。

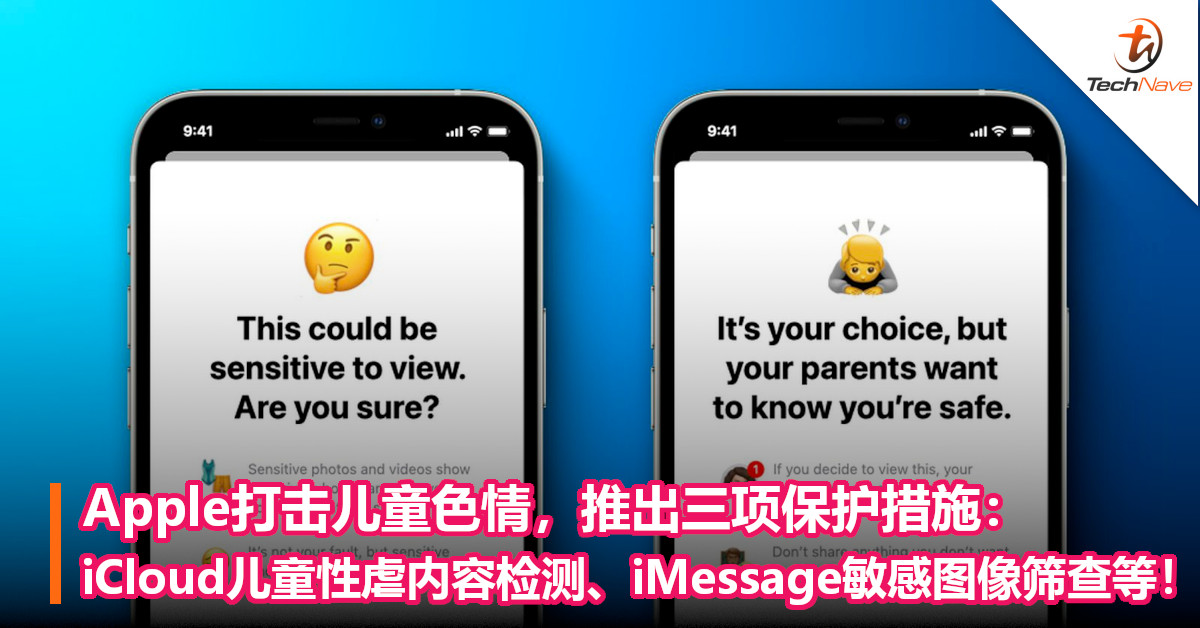

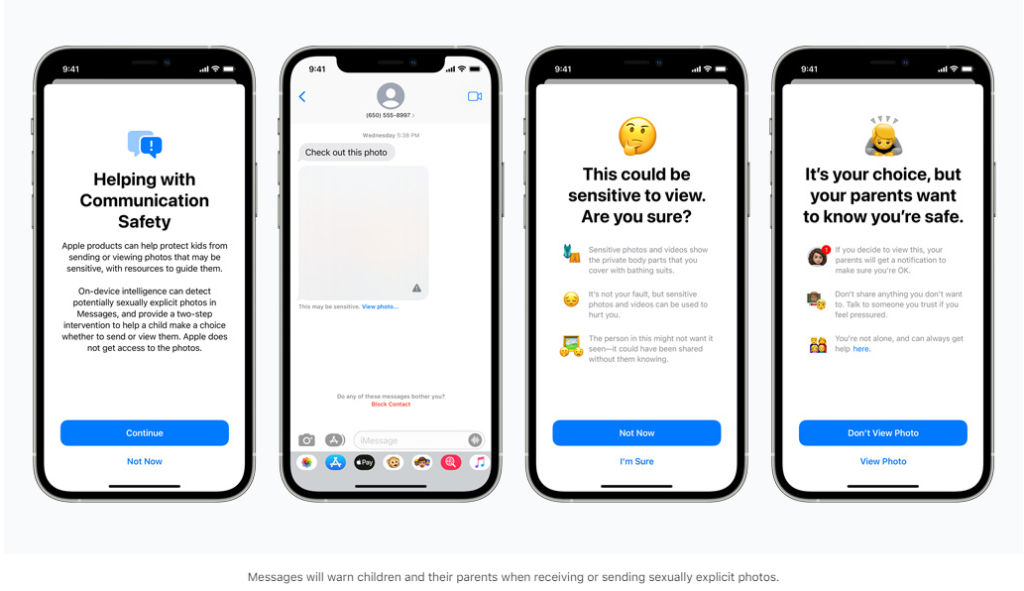

iMessage敏感图像筛查

Apple在其iMessage更新了一项通信安全功能,在使用iCloud的家庭中,若孩子收到或尝试发送色情照片时,将会看到一条警告消息。当孩子收到色情图片时,图片会变得模糊,iMessages同时也会显示一条警告,称该图片“可能很敏感”。

如果孩子点击“查看照片”,则会看到一条弹出消息,告知为什么该图像被判定是敏感的。

此外,如果孩子试图发送色情图片也会看到类似的警告。Apple表示,在发送照片之前,孩子会收到警告,如果孩子选择发送照片,父母可以收到一条消息,此功能适用于13岁以下的孩子。

iMessage使用设备上的机器学习功能来分析图像附件,并判定照片是否具有色情内容。 同时,因为iMessage是端到端加密,Apple自己也无法看到任何信息内容。

这项功能将首先于美国推出,未来将在iCloud中为家庭账户开放,并在iOS 15、iPadOS 15和macOS Monterey的更新中推出。

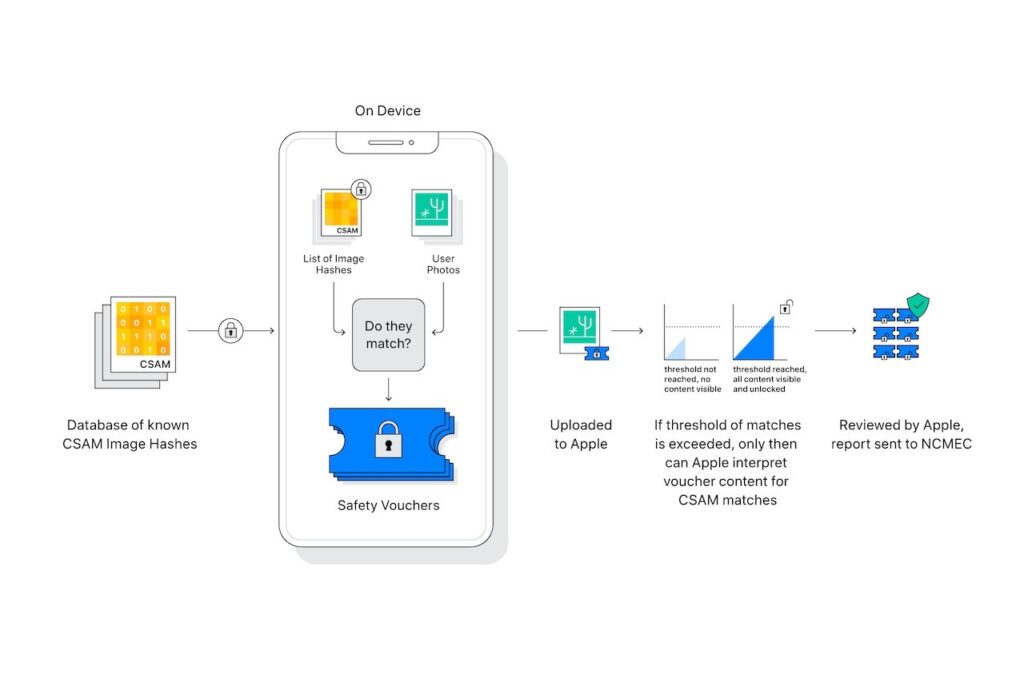

iCloud儿童性虐待内容检测

Apple宣布采取新措施来打击儿童性虐待内容 (CSAM) 的传播,这类内容主要是指涉及儿童的色情活动的内容。

这项功能将允许Apple检测存储在iCloud云端照片中的这类图像,继而可以向国家失踪和受虐儿童中心报告实例,该中心会与执法部门密切合作。

Apple将通过将照片与国家失踪和受剥削儿童中心提供的已知儿童性虐待材料数据库(CSAM)进行比对,来检测虐待图片。该公司使用了一种名为NeuralHash的技术,可以分析图像并将其转换为一组独特的数字。然后将该密钥与使用密码学的数据库进行比较。

Apple表示,设备上的系统更重要且更能保护隐私,因为它只报告拥有儿童性虐待内容的用户,而不是在云端不断扫描每个人的照片。

Siri和搜索功能改进

Apple同时也正在对Siri和搜索功能进行升级,通过提供额外资源来帮助儿童和父母保持网上安全,如果在不安全时候可通过Siri和搜索获得帮助指导。

例如,询问Siri如何报告儿童性虐待内容或剥削童工,这些功能将告诉用户在哪可以汇报给有关部门。Siri和搜索功能更新也将于今年内在iOS 15、iPadOS 15、watchOS 8和macOS Monterey的更新中推出。

更多科技资讯,请继续守住TechNave中文版!

【资料来源】